Il concetto di spaventoso in matematica si può ricondurre a qualcosa che, per qualche ragione, causa nel lettore paura, incertezza o timore nell’accettare che quella realtà sia effettivamente come ci ritroviamo a descriverla.

Il candidato di questa riflessione è la legge di Zipf, una distribuzione di probabilità dal significato terrificante.

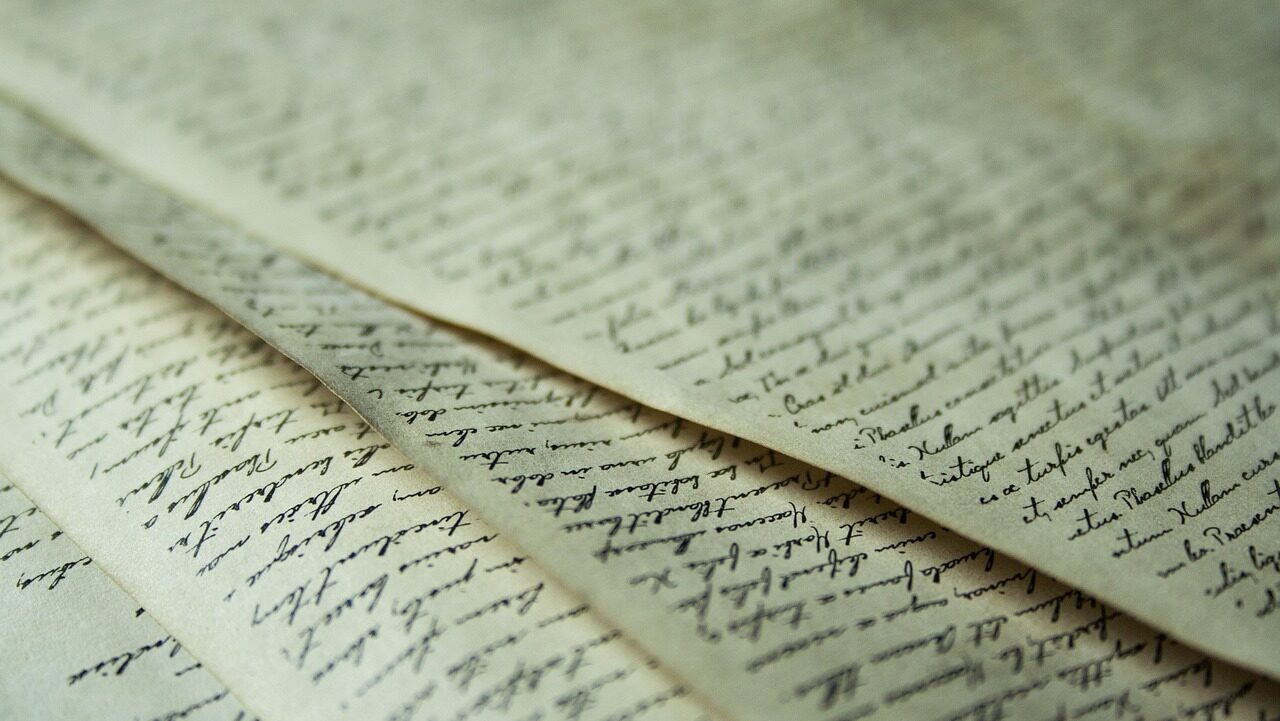

Nel 1935 il linguista statunitense George Kingsley Zipf (Freeport, 1902 – Newton, 1950) notò uno schema peculiare nella frequenza delle parole. Studiando il comportamento della ripetizione delle parole in qualsiasi testo inglese abbastanza lungo, si accorse che, contando il numero di volte con cui ogni parola si ripete, la più frequente appare due volte più spesso della seconda più frequente. Questo non è tutto: la terza parola più frequente appare un terzo delle volte rispetto alla prima, la quarta un quarto e così via.

A titolo di esempio, si consideri la raccolta di testi in inglese, per un totale di circa un milione di parole, presente al link “Corpus – Wikipedia”. La parola più frequente è “the”, che appare 69.971 volte. La seconda parola è “of”, per un totale di 36.411 volte, circa la metà di 69.971 entro un errore dell’1 per cento. La parola successiva è “and”, che appare 25.852 volte.

È interessante notare che questa corrispondenza vale per qualsiasi collezione di testi: le opere teatrali di Shakespeare, tutte le pagine di Wikipedia per esempio e via dicendo.

La legge di Zipf non vale solamente per la lingua inglese, vale per l’italiano e tutte le altre lingue, perfino quelle antiche, quelle che non sono state decifrate e anche quelle artificiali, come l’esperanto e il klingon.

La legge di Zipf è una legge empirica, ossia una legge basata sull’osservazione: per quanto lo schema sia stato confermato da tempo, nessuno è mai stato in grado di spiegarlo.

In questo contesto, si può citare Sander Lestrade, linguista dell’Università Radboud (Paesi Bassi). Lui spiega che questa dinamica potrebbe derivare dall’interazione in un testo tra la struttura delle frasi (sintassi) e il significato delle parole (semantica). Tramite simulazioni computazionali, Lestrade è stato in grado di mostrare che né la sintassi né la semantica riescono da sole ad indurre una distribuzione zipfiana, ma la loro combinazione invece ha successo.

In realtà, queste osservazioni hanno una storia ben più articolata. Zipf si ispirò al principio di Pareto. Nel 1896 l’economista italiano Vilfredo Pareto si accorse che l’80% dei terreni era di proprietà del 20% della popolazione. Inoltre, osservò che il 20% dei baccelli conteneva conteneva l’80% dei piselli. Il fatto è che questo tipo di proporzione si ritrova ovunque in natura, per esempio nel 1989 il 20% della popolazione possedeva l’82.7% delle ricchezze; negli Stati Uniti il 20% dei pazienti usava l’80% delle risorse mediche.

È affascinante, e soprattutto inspiegabile allo stato attuale, che la legge di Zipf trova riscontro nella statistica di eventi non connessi alle parole. Dalla magnitudine dei terremoti alle mosse di apertura

negli scacchi, dal diametro dei crateri sulla Luna al traffico dei siti Internet.

Non c’è niente di più terrificante di un mistero che continuiamo ad osservare. Il linguaggio è una caratteristica umana così dinamica, variabile, soggettiva e oggettiva in certi termini, idiosincratica, profonda. Ogni modo di esprimersi umano è unico, risultato di migliaia di anni di cambiamento, di coscienza collettiva di migliaia di esseri umani che lo hanno plasmato con le loro esperienza, con il loro dolore, con le loro gioie, eppure, l’osservazione mostra che tutte le lingue seguono lo stesso schema apparentemente semplice. E come dicevamo, non solo, la legge di Zipf è altrettanto valida nel sociale, nella psicologia, nella geologia, nell’economia e persino in politica.

La matematica è la ricerca della complessità e della bellezza. Alle volte, nei suoi schemi, si trova qualcosa di inquietante.